De la nube a la tierra, Galicia explora algoritmos que frenen el daño al planeta: «Na competición polo mellor ''chatbot'', non quero pensar nos recursos que están a empregar»

MERCADOS

Son referentes en sus respectivas disciplinas y se han unido en un grupo de investigación que aspira a posicionarse a nivel global en el desarrollo de una inteligencia artificial de bajo consumo

19 may 2024 . Actualizado a las 09:28 h.Para comprender la magnitud del reto, lo primero es preguntarse: ¿Qué entendemos por industria contaminante? La imagen que probablemente venga a nuestra cabeza es la de una chimenea expulsando humo. Una situación que no asociamos ni a la red ni a los dispositivos gracias a los que producimos y difundimos esta noticia. La nube e internet parecen blancos y etéreos, pero para que la conexión no falle y la información se guarde hacen falta toneladas de cobre, cables que atraviesan océanos y centros de datos que ocupan áreas kilométricas. A modo de ejemplo, el data center más grande de Europa, en Kolos (Noruega), abarca dos millones de metros cuadrados. Con el bum de la inteligencia artificial y el uso popular de aplicaciones como ChatGPT las cifras de agua, energía y emisiones de CO2 se disparan.

Sin embargo, la sociedad está lejos de asimilar aún que detrás de un clic hay, además de mucha ciencia, ingentes recursos. Por eso, en el grupo formado por una veintena de investigadores de la Universidade da Coruña (UDC) que lidera la ingeniera informática Verónica Bolón Canedo (Carballo, 1984), desde el 2022 miembro de la Real Academia de Ciencias Exactas, hay expertos en lingüística, derecho, psicología o economía, además de matemáticos e informáticos. «Hai moitísimos custes enerxéticos ocultos detrás da tecnoloxía», introduce Bolón.

Su equipo opera en el Centro de Investigación TIC (Citic), vinculado a la universidad y germen de un puñado de spin-offs de base tecnológica en A Coruña, la ciudad elegida por el Gobierno para albergar la Agencia Española de Supervisión de la Inteligencia Artificial (Aesia), la primera de Europa. El campo de la inteligencia artificial sostenible en el que son uno de los grupos científicos pioneros afronta el 2024 con una buena noticia. El Ministerio para la Transformación Digital les ha concedido una de las 21 cátedras de la Estrategia Nacional en Inteligencia Artificial (ENIA) para su proyecto: la Cátedra UDC-Inditex sobre algoritmos verdes, o cómo desarrollar aplicaciones de inteligencia artificial de bajo consumo. Su propuesta fue la segunda mejor valorada y tiene el respaldo de Inditex, que los financiará, al menos otro año más, cuando en diciembre del 2025 agoten los 900.000 euros procedentes de los Next Generation.

Los dos caminos

«Esta investigación sáese do que están a facer as grandes multinacionais», sostiene Verónica Bolón. Ante la carrera que lideran Microsoft, Google y OpenAI (la empresa que fundaron, entre otros, Elon Musk y Sam Altman y que está detrás del fenómeno ChatGPT), su equipo científico va a contracorriente. «Cando envías unha consulta a ChatGPT, hai un consumo. Pero, ademais, está o tempo de aprendizaxe dos algoritmos. En grandes modelos poden ser meses, isto require de súper ordenadores en grandes centros de datos que consumen cantidades inxentes de enerxía así como de auga para a súa refrixeración. Na competición polo mellor chatbot, non quero pensar nos recursos que están a empregar», explica la ingeniera.

Para amortiguar este impacto aspiran a ser un referente internacional en inteligencia artificial verde. En su estudio abordan dos campos de actuación. Por un lado, «queremos que os algoritmos sexan máis eficientes de xeito que usen menos datos e a súa aprendizaxe dure menos», detalla Verónica. Este es el primer paso.

Además, hay que tener en cuenta que «o software fai os cálculos, obriga a facer as operacións, é o hardware realmente o que contamina». Los grandes modelos de inteligencia artificial necesitan tarjetas gráficas muy potentes, «cuns chips que fan operacións moi complexas. Na industria xa se traballa para conseguir tarxetas máis eficientes partindo dunha forma de almacenar os datos máis efectiva», continúa Bolón.

En su equipo han conseguido ejecutar algoritmos que se realizan con los 64 bits habituales de un ordenador con 32 o 16 bits sin perder precisión. «O bit é a unidade de información más pequena. Temos experimentos mesmo con 8 bits. Isto fai que os ordenadores sexan máis rápidos, consuman menos e precisen menos almacenamento. Abre a porta a empregar dispositivos pequenos no lugar de enviar todo a súper computadoras. Segundo o caso, penso que hai que comezar a pensar se paga a pena adestrar un algoritmo para que mellore un 0,01 % un rendemento. Non é o mesmo intentar detectar unha enfermidade que recomendar unha serie en Netflix», enfatiza Bolón.

En la segunda vertiente de la cátedra entran en juego investigadores como el estadístico Javier Tarrío. «Buscamos hacer más eficientes energéticamente los edificios. Los algoritmos ayudan a que las instalaciones sean más sostenibles», aclara el matemático. La inteligencia artificial, por tanto, también puede ser parte de la solución.

«Aportamos herramientas estadísticas que detectan anomalías. Nuestro combustible son los datos que recogen los sensores. Cuando reduces el consumo de energía, reduces las emisiones», argumenta el matemático. Y los gastos en la factura. Por eso, energéticas e instaladoras trabajan desde hace tiempo con investigadores de la universidad. «Fueron las primeras compañías que contactaron con nosotros. Ofrecen las aplicaciones que desarrollamos a hospitales, hoteles o multinacionales. A partir de plataformas web conectadas a sensores reciben información en tiempo real de todas sus instalaciones: de temperatura, humedad, consumo de cada sala o climatización», precisa Tarrío.

«Un dos potencias da intelixencia artificial é a predición. Se podes predicir cando vai haber un pico de consumo, iso axuda a optimizar os recursos. Por exemplo, nunha tenda. Pero isto non ten por que aplicarse só ao ámbito privado. Tamén ao público. Podemos saber cales son as rúas máis transitadas e a que horas nunha cidade», indica Verónica Bolón, en relación a las smart cities o ciudades inteligentes.

Aunque buena parte de los integrantes del grupo que busca algoritmos que dañen menos el planeta están vinculados al Citic, uno de los centros investigadores reconocidos como singulares en Galicia y donde la cifra de científicos se aproxima a los 300, también hay profesionales de otras facultades y campus de la UDC.

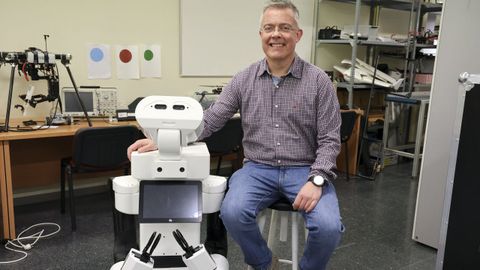

Desde Ferrol, el experto en robótica Richard Duro aporta su experiencia con la arquitectura cognitiva. «La inteligencia artificial no son solo redes profundas o neuronales. Es decir, una forma de procesado que trata de imitar las redes neuronales humanas donde la filosofía es: aprender de cero, como los niños. Hay un problema en esto, los humanos no lo aprendemos todo desde cero, venimos con muchas capacidades programadas. Estamos predispuestos a hablar o tomar el pecho, moriríamos si tuviéramos que aprender todo de cero. Si quieres un sistema cognitivo de verdad tienes que incluir nuestro conocimiento, que es un conocimiento de especie. ¿Cómo se introduce en los robots? Desde hace 40 años se buscan maneras de alcanzarlo. Y en eso estamos», explica Duro.

Los sistemas robotizados van a seguir implantándose en nuestra industria y en nuestra vida. Es algo imparable. Una de las contrapartidas es que, tanto en su fabricación como en su uso, «el consumo de energía es mucho mayor que en un ordenador», incide. Además, al ser dispositivos muy complejos, están hechos prácticamente para una única tarea, «por eso, buscamos generar robots más autónomos, que se adapten a diferentes tareas con muy pocas indicaciones del usuario. Así necesitaremos fabricar menos. Pero, para llegar aquí tienen que tener una capacidad cognitiva en entornos humanos que todavía no hay, pero empieza a vislumbrarse», avanza el investigador.

¿Solo importa la persona?

Todo va enfocado a reducir la huella de carbono. Según un estudio de la Universidad de Copenhague, una única sesión de entrenamiento de GPT-3 (la base de ChatGPT) tiene un consumo energético equivalente al de 126 casas danesas en un año. Otro de la Universidad de Lancaster eleva al 20 % las emisiones de CO2 de las tecnologías de la información, más que la industria de la aviación. No solo eso, estima que para el 2025 las emisiones por el uso de internet serán similares a las que genere el cuarto país con mayor impacto medioambiental del mundo, por detrás solamente de Estados Unidos, China e India.

«Canto contamina adestrar un algoritmo? Hai moitos datos que non se están a revelar por parte destas compañías, pero si sabemos que unha consulta en ChatGPT contamina moito máis que unha en Google, que o vai facer igual e de forma máis eficiente. Por exemplo, para unha tradución. A xente non é consciente disto. Alarmámonos polas emisións dos voos, pero non por isto. Hai que traballar a concienciación», ilustra Bolón.

A cuentagotas se van conociendo algunas cifras, como las que ofrece el AI Index Report 2024 de la Universidad de Stanford (EE.UU.) Algunos de los titulares que arroja tienen que ver con el gasto estimado en millones de dólares del entrenamiento de modelos de inteligencia artificial. Una cantidad que se ha disparado entre el 2017 y el 2023. En el informe, elevan a 78.352.034 dólares el coste de entrenamientos de modelos GPT-4 (el modelo de lenguaje de OpenAI que sigue a la versión de GPT-3); en 191.400.000 los de Gemini Ultra (de Google) y en 3.931.897 dólares los de Llama 270B (el modelo de lenguaje desarrollado por META y respaldado por Microsoft).

En este mismo informe también se hizo una comparativa entre las emisiones de CO2 en toneladas equivalentes entre modelos de aprendizaje automático y situaciones de la vida real entre los años 2020 y 2023. Si 63 coches emiten 63 toneladas de CO2 durante su vida útil, el desarrollo del modelo de aprendizaje de GPT-3 (175B) supuso 500 toneladas en el 2020.

Otros estudios, como The growing energy footprint of artificial intelligence (La creciente huella energética de la inteligencia artificial), desde Ámsterdam, profundizan en el consumo de energía estimado por solicitud de varios sistemas impulsados por inteligencia artificial en comparación con una búsqueda estándar de Google. Si una petición en este buscador implica unos 0,25 vatios hora, una en ChatGPT requiere 2,90.

Pero, estas cifras apenas llegan o impactan en el usuario. «Hasta ahora primó la visión antropocéntrica», resume la doctora de Dereito de la UDC Patricia Faraldo, integrante del equipo. «En Europa se ha llegado a un acuerdo en el reglamento sobre inteligencia artificial que deja fuera la variante ambiental de los factores por los que se puede considerar de alto riesgo su implementación. Todo está centrado en el ser humano, hace falta una perspectiva ecocéntrica», alega Faraldo, con experiencia en protección penal del medio ambiente, por un lado, y en el abordaje de los riesgos ético legales de la aplicación de la inteligencia artificial en el campo policial en el rastreo de redes sociales, por otro. Dos áreas que ahora integra en la cátedra.

Que España aprobase recientemente un Plan Nacional de Algoritmos Verdes es un primer paso. «Hay que trabajar de arriba abajo en esta concienciación. Por tanto, hay que empezar por los que desarrollan inteligencia artificial. Es fundamental que los propios desarrolladores se impliquen», avisa Faraldo. De ahí el valor de estos equipos transversales, donde los abogados trabajan con los informáticos o los economistas.

En esta línea, prosigue Verónica Bolón, «imos estudar as implicacións sociais, éticas e legais dos algoritmos verdes. Por exemplo, na regulación. Ata o momento, o foco está posto en respectar os dereitos das persoas. Pero non imos á dimensión superior, que todo isto tamén contamina. Queremos investigar as propostas de regulación dos países e ver se teñen en conta ao medio ambiente como un ben xurídico a manter», anticipa la investigadora principal de la cátedra.

Su compañero, el especialista en robótica Richard Duro, es consciente de las reticencias que generan avances tecnológicos y científicos como el campo en el que trabajan. «Es lo mismo que en biología. No tendríamos que temerle a los clones, sino a los humanos capaces de hacerlos. Con los robots pasa igual, no son los malos. Los humanos son los malos», asevera Duro.

De momento, el sector privado se rige por la autorregulación y apenas existen normas vinculantes en esta materia. La autoevaluación de riesgos y los reglamentos que obliguen a las empresas a tener en cuenta el respecto al medio son dos de sus propósitos. «No es suficiente con decir que la inteligencia artificial es un un factor contaminante, se trata de aplicar principios ambientales en su desarrollo, evaluar el riesgo, prevenir. Tenemos que poner los medios para que los algoritmos sean transparentes, justos, robustos, explicables y auditables», concluye la especialista en derecho Patricia Faraldo.

El uso del móvil o del ordenador es limpio en el sentido de que no producen emisiones, pero requieren de un consumo elevado de agua y electricidad. El agua es cada vez más escasa y la electricidad hay que producirla. Los científicos son conscientes de que tienen que visualizarlo, sensibilizar acerca de los recursos que implica una consulta en ChatGPT y su entrenamiento. Difundir estos datos y cuál es la meta que persiguen también es una parte esencial de su trabajo.